DeepSeek-R1-1.5B

CPU:最低4核(推荐多核处理器)

内存:8GB+

硬盘:3GB+存储空间(模型文件约1.5-2GB)

显卡:非必需(纯CPU推理),若GPU加速可选4GB+显存(如GTX 1650)

适用场景:低资源设备部署(如树莓派、旧款笔记本)、实时文本生成(聊天机器人、简单问答)、嵌入式系统或物联网设备

DeepSeek-R1-7B

CPU:8核以上(推荐现代多核CPU)

内存:16GB+

硬盘:8GB+(模型文件约4-5GB)

显卡:推荐8GB+显存(如RTX 3070/4060)

适用场景:本地开发测试(中小型企业)、中等复杂度NLP任务(文本摘要、翻译)、轻量级多轮对话系统

DeepSeek-R1-8B

CPU:与7B相近,略高10-20%

内存:与7B相近,略高10-20%

硬盘:与7B相近,略高10-20%

显卡:与7B相近,略高10-20%

适用场景:需更高精度的轻量级任务(如代码生成、逻辑推理)

DeepSeek-R1-14B

CPU:12核以上

内存:32GB+

硬盘:15GB+

显卡:16GB+显存(如RTX 4090或A5000)

适用场景:企业级复杂任务(合同分析、报告生成)、长文本理解与生成(书籍/论文辅助写作)

DeepSeek-R1-32B

CPU:16核以上(如AMD Ryzen 9或Intel i9)

内存:64GB+

硬盘:30GB+

显卡:24GB+显存(如A100 40GB或双卡RTX 3090)

适用场景:高精度专业领域任务(医疗/法律咨询)、多模态任务预处理(需结合其他框架)

DeepSeek-R1-70B

CPU:32核以上(服务器级CPU)

内存:128GB+

硬盘:70GB+

显卡:多卡并行(如2xA100 80GB或4xRTX 4090)

适用场景:高精度复杂任务、大规模数据处理

本地部署:整合 Open WebUI、Ollama 和 DeepSeek-r1

Open WebUI 提供了一个简洁的 Docker 化解决方案,用户无需手动配置大量依赖,直接通过 Docker 启动 Web 界面。

首先,服务器上需要确保已经安装了 Docker ,如果没有安装,可以通过以下命令进行快速安装:

curl https://get.docker.com | sh对于Debian/Ubuntu:

sudo apt update

sudo apt install -y docker-ce docker-ce-cli containerd.io对于CentOS/RHEL:

sudo yum install -y docker-ce docker-ce-cli containerd.io对于Fedora:

sudo dnf install -y docker-ce docker-ce-cli containerd.io

接下来,我们可以通过以下命令来启动 Open WebUI :

docker run -d -p 3000:8080 -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama如果想要运行支持 Nvidia GPU 的 Open WebUI ,可以使用以下命令:

docker run -d -p 3000:8080 --gpus=all -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama这里我们将 Open WebUI 的服务暴露在机器的 3000 端口,端口如果被占用,可自定义修改,最后可以通过浏览器访问 http://localhost:3000 即可使用(远程访问则使用公网 ip ,开放 3000 端口)。/data/open-webui 是数据存储目录,你可以根据需要调整这个路径。

第一个注册的用户将被自动设置为系统管理员,所以请确保你是第一个注册的用户。

点击左下角头像,选择管理员面板

点击面板中的设置

关闭允许新用户注册(可选)

点击右下角保存

配置 DeepSeek模型

启动 Ollama 服务(如果是 Docker 方式启动则不需要,但必须暴露 11434 端口):

ollama serve通过 Ollama 安装 deepseek-r1,你可以直接在命令行中运行 ollama pull 命令来下载 deepseek模型,比如要下载 deepseek-r1:1.5b 模型,可以使用以下命令:

ollama run deepseek-r1:1.5b

对于其它模型:可访问官网地址获取:https://ollama.com/library/deepseek-r1

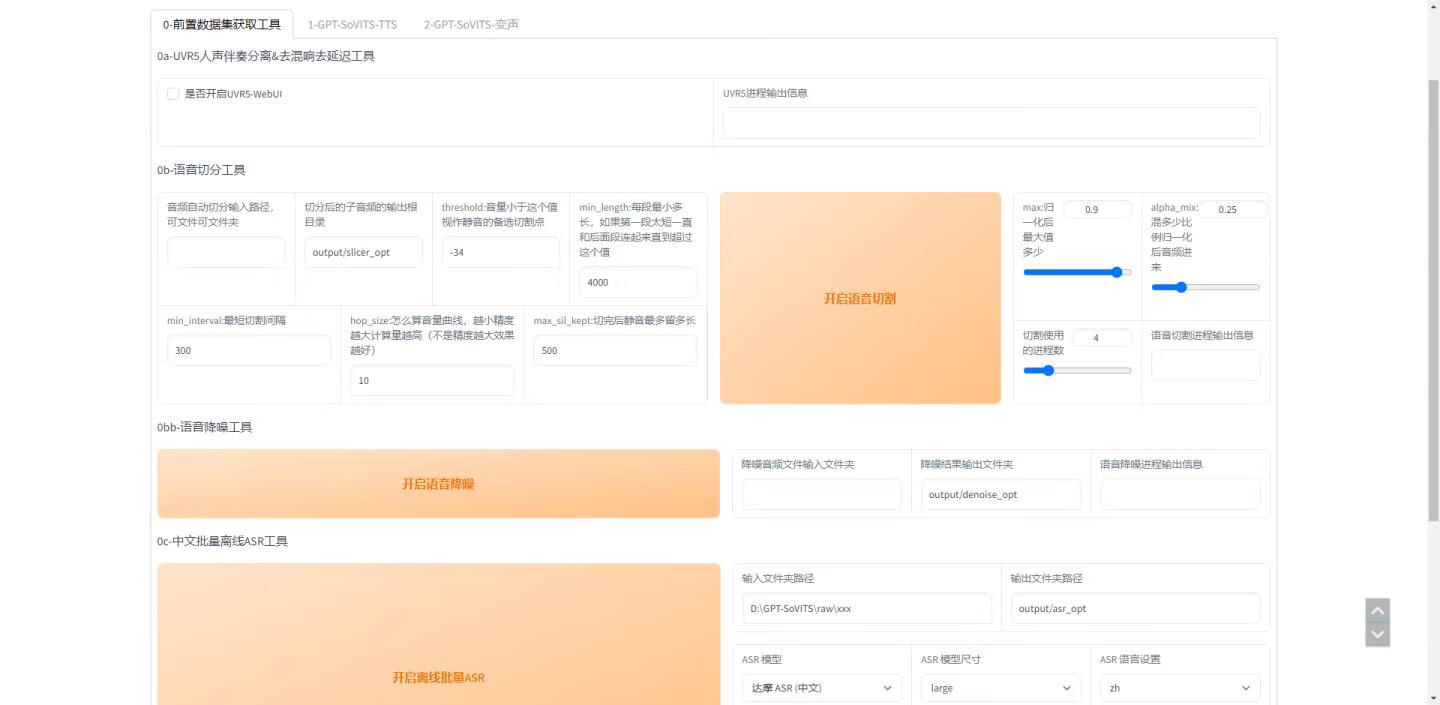

通过webui拉取模型:

![图片[1]-DeepSeek-R1系列模型部署所需的最低硬件配置如下:-逃课猫Deepfacelab|AI智能研究站](https://b.bdstatic.com/comment/7i4cDXE9vAjsWQuiBMto6wb6f56d59aeb8fd90f1cb3280ab2b693d.jpg)

1、该资源仅供学习和研究传播,大家请在下载后24小时内删除,一切关于该资源商业行为与逃课猫智能研究站(taokemao.cn)无关。

2、请勿将该软件程序进行商业交易、转载、违法运营等行为,该软件只为研究、学习所提供,该软件程序使用后发生的一切问题与本站无关。

3、若本程序源/码侵犯了您的权益,请及时联系我们予以删除!

4、本程序仅供研究学习使用,切勿商用以及违法使用!

5、本站收费内容,只用于维持域名注册、网页空间租用等费用日常开销。

6、本站免费、含会员内容的软件工具,皆不包含人工技术服务教程等服务,大部份已提供视频教程,请自行网上搜索。